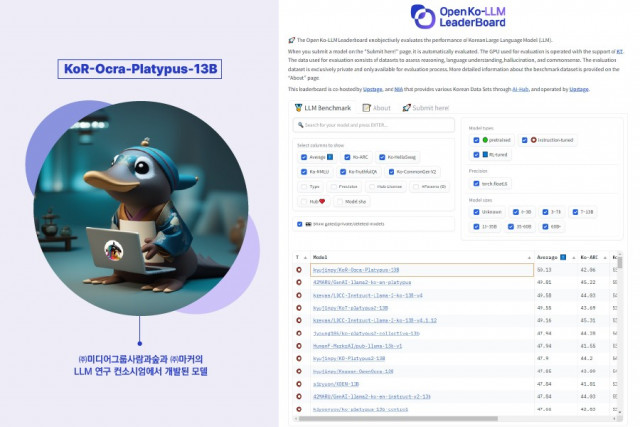

한국어 ChatGPT 개방 경쟁에서 1위를 차지한 ‘KoR-Orca-Platypus-13B’

미디어그룹사람과숲은 한국정보화진흥원(NIA)과 업스테이지가 주최하는 한국어 초거대 언어 모델 리더보드 ‘Open Ko-LLM’에서 마커 사와 공동 개발한 ‘KoR-Orca-Platypus-13B’ 모델이 1위를 차지했다고 밝혔다.

KoR-Orca-Platypus-13B는 글로벌 IT 기업 메타에서 오픈소스로 공개한 파라미터 수 130억개의 언어 모델 ‘라마2(LLaMA-2)’를 파운데이션 모델로 삼고, 자체적으로 수집 및 가공한 데이터에 instruct 파인 튜닝을 거쳐 개발됐다.

거대 언어 모델(LLM)들의 한국어 성능을 겨뤄보는 이번 리더보드는 제출된 LLM에 대해 추론 능력, 상식 능력, 언어 이해력, 환각 방지 능력, 한국어 상식 생성 능력 등 5가지 항목을 평가해 순위표를 제공한다. 10월 20일 현재 50개 이상의 개인 및 조직에서 100개 이상의 LLM이 제출됐으며, ‘KoR-Orca-Platypus-13B’ 모델이 평균 점수 50.13으로 1위를 기록하고 있다. 특히 5가지 평가 지표 가운데 한국어 상식 생성 능력은 68.78로 압도적인 성능을 나타내고 있다.

미디어그룹사람과숲은 이번 결과가 9월 28일부터 이전 모델인 ‘KO-Platypus2-7B-ex’로 수차례 1위을 기록하면서 모델 성능을 업그레이드한 성과라고 설명했다.

연구팀을 이끈 정철현 박사는 “이번 LLM 개발은 AI-Hub의 한국어 공공 행정 문서와 민원 응대 데이터가 주요 데이터 소스로 활용됐다”고 밝혔다. 그는 이어 “이 LLM은 공공 행정 업무를 수행하는 챗봇에 탑재하기 위해 튜닝한 것이지만, 종합 성능이 국내 1위 수준이므로 더 다양한 용도로도 활용할 수 있을 것”이라고 전망했다.

미디어그룹사람과숲 한윤기 대표는 “그동안 AI 학습용 데이터셋 구축 사업에 집중해 얻은 노하우를 활용해 데이터셋을 구축한 덕에 뛰어난 LLM을 개발할 수 있게 됐다”고 자평하며 “앞으로도 한국어 AI의 기술 발전에 계속 기여하고, 특히 공공 행정 분야에서 가장 사랑 받는 한국형 ChatGPT를 만들어 나가겠다”고 포부를 밝혔다.